时隔一年,2026年大模型行业“春节档”又要来了。近期的外媒报道显示,这场春节档竞争即将在2月进入白热化。

字节跳动计划在下个月推出三款全新的 AI 模型,分别为豆包 2.0(新一代旗舰大语言模型)、Seedream 5.0(图像生成模型)以及 SeedDance 2.0(视频生成模型)。

另一方面,阿里同样计划在春节假期期间发布新一代旗舰 AI 模型Qwen 3.5。据悉,该模型在数学推理和代码能力方面表现突出。有外部分析显示,来自中国头部AI企业间的竞争,可能在未来数年内深刻塑造14 亿人口使用 AI 的方式。

本月,已经有多家头部厂商在推出或更新关键模型,加速围绕春节档展开的“AI竞赛”。近日DeepSeek团队开源了DeepSeek-OCR2模型,月之暗面发布了其旗舰模型KimiK2.5,阿里巴巴也推出了旗下Qwen3-Max-Thinking旗舰推理模型。

换言之,2026年的AI春节档,将是一场跨越模型到产品层面的全面竞争。在产品前端,元宝、豆包、千问正在打响春节AI红包大战;而在模型侧,大家都不想放过下一个“DeepSeek时刻”。

这一趋势的起点,可以追溯到2025年春节前后。彼时,DeepSeek-R1因较低成本和强大推理能力一度冲击海外应用排行榜,成为国内大模型破圈现象级事件,也让春节档成为行业观察的关键时间窗口。

从目前已知的模型信息来看,今年的春节档竞争不仅是围绕单一模型能力的对比,更是多模态能力、推理性能与应用生态的综合较量。

此前,有报道披露,其下一代旗舰模型DeepSeek V4,预计将于马年春节前后发布。该模型内部测试显示,其在代码生成和长上下文处理能力上优于现有主流大模型,成为业内密切关注的焦点之一。

所以,这个春节档,友商们面对春节档的热情也就不难理解了。

这个马年春节,AI行业注定会上演一场“万马奔腾”。

01

榜单之外,实际场景很重要

过去的一周内,春节来临前的“模型上新”正在演变成一场声量竞赛。

DeepSeek开源OCR2、Kimi发布并开源K2.5、阿里发布Qwen3-Max-Thinking,中国模型海内外AI产品热点中三度“同框”,业内对于大模型“下饺子”的讨论氛围也不断升温。

近日,阿里千问发布了Qwen3-Max-Thinking推理模型,加入了今年的春节档“模型赛马”。从时间点上看,这一发布落在春节档窗口期,与近期阿里在AI方向上的一系列动作形成呼应。

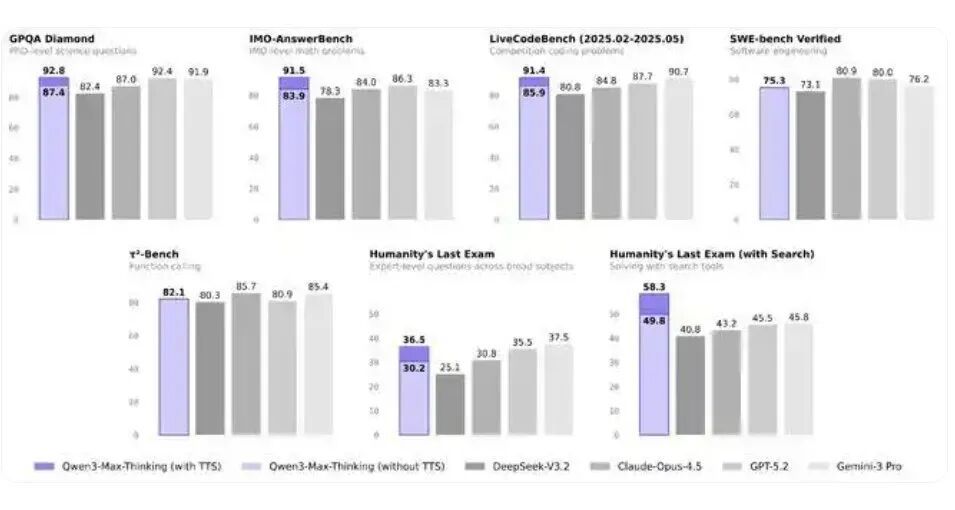

阿里方面披露的信息显示,该模型总参数超万亿、预训练数据量达36Ttokens,在19项基准测试中展现出与GPT-5.2-Thinking、Claude-Opus-4.5和Gemini3Pro等顶尖闭源模型相当甚至更优的性能。

与此前围绕参数规模或榜单名次的发布不同,这一代模型的技术取向并未继续拉大参数差距,而是将重心放在推理稳定性与工具使用能力上。

阿里云官方博客显示,Qwen3-Max-Thinking的核心亮点集中在两个方面。第一个是自适应工具调用能力,模型可以在对话过程中自主决定是否调用搜索引擎、记忆工具或代码解释器。

这种设计的直接效果,是减少不必要的工具调用,让模型在需要实时信息时触发搜索,在需要计算验证时调用代码解释器,从而降低幻觉概率,也让交互路径更短、更可控。

第二项创新是测试时扩展技术。这个技术的核心思路是让模型在推理过程中进行多轮自我反思。但与简单增加并行推理路径不同,Qwen3-Max-Thinking采用了一种“经验累积”机制,在多轮推理中提取已有结论,将算力集中在尚不确定的环节上,以提升整体推理效率。

从公开数据来看,这种取向并非追求单点最优。在部分知识类基准中,Qwen3-Max-Thinking模型成绩存在差异:例如在C-Eval上略高于Gemini3Pro,而在MMLU-Redux上并未全面领先。

换言之,Qwen这一次主打的是降低交互的复杂度,让模型更接近一个“能直接办事”的接口,这也点出了2026年春节档模型赛马的一个重要主题:推理效率和可控性。

从行业层面看,这一取向并非个例。几周前,腾讯CEO、首席AI科学家姚顺雨在AGI-Next峰会上公开表示,希望中国AI能逐步走出榜单束缚,把注意力更多放在长期正确的方向上。

近期的多款模型更新,也验证了这一变化正在发生。

另一方面,Qwen3-Max-Thinking的发布时间,也处在一个相对敏感的节点。此前,曾有报道传出,阿里和千问在央视2026春晚的竞争中不敌字节的豆包,而近期,腾讯元宝等原生C端AI产品也相继发力,借助红包和互动玩法快速放大存在感。

AI应用层面的“春节团战”,反过来放大了模型侧更新的必要性。在超级入口资源有限的前提下,通过模型发布进入讨论中心,是一种合理甚至必然的选择。

这一判断,也与阿里近期的产品调整相呼应。去年11月,“通义”App更名为“千问”,并成立C端事业群,整合夸克、UC、AI硬件等业务线,明确将其定位为面向普通用户的AI助手产品。

在1月中旬的千问发布会上,阿里集团副总裁吴嘉现场演示了用千问完成点奶茶的操作,强调通过生态协同,让AI能够完成具体事务。但想要支撑更复杂、跨系统的任务,新一代推理模型自然成为底层能力的关键。

当用户询问“附近哪里有好吃的川菜”时,他们期待的已不只是搜索结果列表,而是基于实时信息、个人偏好和地理位置的直接推荐与预订。

也正是在这一由DeepSeek带动的声量窗口下,不只是阿里,更多厂商选择在春节前集中出牌。模型赛马,正在演变为一场多路并进的集体跃进。

02

赛道不止一条,最终要看模型和产品的协同

几乎在同一时间,百度和月之暗面也推进了各自的模型迭代,但这两家公司展示了不同的侧重点。

一周前,百度正式发布了文心5.0,这是一款参数规模达到2.4万亿的全模态模型,支持文本、图像、音频和视频等多种输入形式。官方介绍显示,该模型采用原生全模态统一建模技术,可处理文本、图像、音频、视频等多种输入形式,并已在多款百度产品中上线体验。

大而全,这是文心5.0给人的第一印象,该模型在2024年11月首次对外预览,随后在LMArena排行榜上排名快速上升,目前登顶国内模型榜首。

与模型指标相配合的是百度的分发基础。公开信息显示,百度旗下的文心助手月活跃用户已突破2亿,而文心5.0可通过百度千帆平台、文心一言官网、文心助手等多端调用。

显然,在缺少豆包/千问这样的头部原生AI产品的情况下,百度更倾向于在其既有的搜索与产品入口上强化能力,借助大流量入口让新模型能力更快被用户感知,以巩固自身“大模型第一梯队”的地位。

所以,想要全面在C端产品赋能,就必须走能力覆盖没有短板的全模态路线。

与之形成对照的,是刚完成新一轮融资的月之暗面。

月之暗面在春节前发布了KimiK2.5,这是一款在K2基础上持续预训练的原生多模态模型,使用了约15T的混合视觉与文本token。相比参数规模,Kimi更强调结构与执行方式的变化。

K2.5提出的Agent Swarm范式,是这次更新的核心。模型可以根据任务复杂度,自主组织多达100个子Agent并行执行,减少任务编排和等待时间。官方给出的内部评估显示,在复杂任务中,端到端运行时间可缩短约80%。

围绕这一能力,月之暗面同步推出了Kimi Code和Office Agent等产品形态。前者强调与IDE的集成,后者聚焦办公场景中的文档生成与整理。这些产品并不试图覆盖所有需求,而是集中在“写代码”“做文档”等结果明确的任务上。

以Office Agent为例,只要用户说人话提需求,它直接给你出Word/Excel/PPT/PDF成品,并且生成的内容是非常专业的,用户也不再需要为排版、美化这些事情担心,可以说是打工人的救星了。

不过,OfficeAgent只能停留在微软Office可以实现的范围内,无法像部分通用Agent那样操作更复杂的文件或系统。

从行业角度看,Kimi的路径通过模型结构和产品形态的差异,去吸引开发者和重度用户的注意力。

另一边,DeepSeek在传说中的V4大招之前,也在模型应用侧有了新产出。

作为开源OCR/视觉理解模型,DeepSeek-OCR2可以用于文档抽取、表格识别、票据与截图理解等场景的对照测试。

OCR2在论文中强调通过DeepEncoderV2的“VisualCausalFlow”能力,根据文档语义动态重排视觉token,更贴近多栏、表格与公式的阅读逻辑。

不过相比起传说中的V4,OCR2还只是DeepSeek在春节档的前菜。

横向比较目前发布的几个模型不难发现,尽管在声量上形成了竞争态势,但不同公司的“最优策略”并不统一,而是取决于它们手中已有的筹码。

从行业视角看,2026年春节档的模型赛马,已经很难再用“谁的模型更强”来简单概括。模型更新正在与入口条件、产品形态和传播效率深度绑定。

而对于传说中的DeepSeekV4而言,这意味着想要再现去年的光辉时刻,似乎将会遇到更多的挑战。

03

Coding能力是关键,但不是全部

纵观最近一段时间的通用模型发展方向,行业的关注点正在向一个关键指标上收敛——编程能力。

这一风向的转变,一方面来自AI大厂的内部业务需求,同时也是因为大洋彼岸的同行在过去一年中持续地“上强度”。

2025年,Anthropic发布ClaudeOpus4.5,其在SWE-benchVerified测试中取得80.9%的成绩,成为首个突破80%门槛的模型。Anthropic随后强调,该成绩超过了其内部工程招聘考试中所有人类候选者的表现。

不到一个月后,OpenAI跟进发布GPT-5.2 Codex,在同一测试中取得80.0%的成绩,与Claude Opus4.5基本持平。至此,头部模型在编程基准上的竞争,正式进入了白热化阶段。

从应用角度分析,大厂愿意集中投入编程能力,是因为这是当前商业价值最清晰、付费意愿最强、反馈最快的应用场景。无论是Copilot、CodeInterpreter还是各类Agent工具,编程都是最早跑通商业闭环的领域。

更重要的是,在行业内部,编程能力被视为推理能力的代理指标。代码生成需要模型理解需求、设计结构、处理边界条件,并在出错时进行调试与修正。这是一整套多步骤、强约束的推理过程。

正因为如此,一个在编程任务中表现稳定的模型,往往也能在其他复杂推理任务中维持质量。SWE-bench这类测试,逐渐从“程序员专用榜单”,演变为衡量模型综合推理能力的关键窗口。

所以,当DeepSeekV4传出其在编程相关任务上的表现超过现有主流模型,包括Claude与GPT系列时,2026大模型春节档引发的关注,被抬到了一个新的高度——甚至不亚于2025年初的场景。

据了解,V4的突破并不仅体现在得分本身,还包括对超长代码提示词的解析能力,以及在整个训练流程中维持稳定数据模式理解的能力。

结合去年的R1来看,外界关注的核心并不是它是否全面领先,而是:在相对有限的训练成本下,模型表现接近甚至逼近国际顶尖水平。

V4再次选择春节档,被业内视为一次高度自觉的策略延续——用硬核技术进展,在同一时间窗口内对标全球最强模型,直接争夺开发者与技术社区的注意力。

不过,强调Coding能力的这个特征,却在今年的春节档竞争中形成了一种微妙的张力。

一方面,编程能力是当前模型竞争的“硬指标”;另一方面,编程并不天然适合在春节档展示。与点餐、搜索、生成图片不同,写代码往往需要上下文、时间和专业背景,传播效率并不高。

所以,承载着V4的DeepSeek App,会不会春节档进行产品策略的迭代,同样值得关注。

事实上,随着AI产品在C端全面加速,伴随着元宝等App的红包雨,AI春节档已经不仅仅是要在业内赢得声量,春节期间产品的“可展示性”异常重要。用户需要能够快速看到产品的价值,最好是能够在几分钟内完成一个让人印象深刻的任务。

比如千问“点杯奶茶”演示的例子,就直观地展示了模型的能力,用户可以立即理解这个功能的价值。

相比之下,那些需要长时间使用才能体会到价值的功能,在春节档的传播中就会处于劣势,尤其是像编程这样的能力,在做大声量的环节并不占优势。

也就是说,和2025春节档相比,想要单凭技术迭代,在如今的AI应用市场赢得用户声量并非易事。

大厂相继下场卷AI应用的2026年,模型需要配合产品逻辑进行优化,谁能先呈现出可以被用户快速接受、快速理解的能力,就有望在今年的春节档AI赛马中脱颖而出。

考虑到当前业内的关注度,深度求索和梁文锋,仍然有可能凭借DeepSeekV4再复刻一次“DeepSeek时刻”。只不过,如今的春节档“AI赛马”,已经演变成模型技术、产品玩法、企业声量多个赛道上的大乱斗。

本文转自:凤凰网科技

原文地址: https://tech.ifeng.com/c/8qL4TEtjOxq

小同爱分享23 小时前

所谓生活不如意,就是缺少人民币。 - 小同爱分享

小同爱分享17 天前

我床上有两个枕头,一个是我的,另一个还是我的。 - 小同爱分享