离了大谱了,AI真·走进了大学期末考场,并且还是以作弊者的身份。(你就说震不震惊吧)

没开玩笑,事情就发生在香港科技大学《计算机网络原理》的本科期末考试“现场”。

一副搭载ChatGPT-5.2模型的AI眼镜,被直接戴上鼻梁,在复刻真实考试条件的情况下,完成了整套期末试卷:

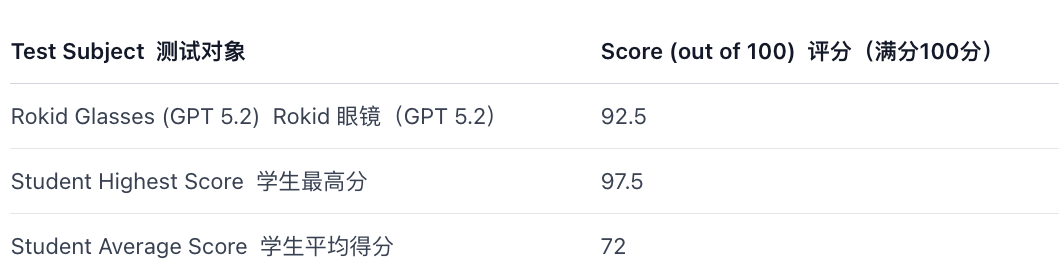

结果甚是魔幻:30分钟交卷,狂揽92.5分,并在一百多人的排名里跻身进了前五,轻松碾压超95%的人类考生:

果然,一代人有一代人的学习工具,以前是小抄复习资料,这回直接升级成——「整机」。

只不过,当这套整机已经能完整跑完一整套考试流程时,大家关注的重点,可能不再只是AI会不会答卷了。

这一次,AI“作弊者”只是像人类学生那样完整答了一遍题,却让传统的教学评估体系看起来似乎有点站不住脚。

一副AI眼镜,跑完了一整场大学期末考试

这场看似离谱的「人机同场考试」,可不是学生的临时整活,而是由香港科技大学张军教授、孟子立教授团队主导的一场实验。

目标很明确,那就是让一副搭载大模型的AI眼镜,光明正大地在考场“作弊”,然后看它能考多高分~

其选中的测试场景也是非常的简单粗暴,直接瞄准了令无数大学生《闻风丧胆》的专业课——计算机网络原理。(瑟瑟发抖…

这门课程不仅考查海量的专业概念,更涉及严密的逻辑推导与算法应用,对人类学生来说是不小的挑战,对AI而言更是难度拉满。

对此,为了让这位AI考生发挥出最强实力,项目组在「软硬件」筛选上可谓是做足了功课!

在硬件筛选环节,项目团队对市面上12款主流商业智能眼镜进行了系统评估,其中也包括大家熟悉的Meta、小米、乐奇Rokid等厂商的产品:

第一轮筛选后,团队发现真正同时具备内置摄像头和集成显示屏的产品其实并不多,进入候选范围的主要只有Meta Ray-Ban、Frame,以及乐奇Rokid。

但实验还需要进行二次开发,尽管Meta提供了设备访问工具包,但并未开放对显示内容的直接控制接口,难以满足实验对信息呈现方式的要求。

相比之下,乐奇Rokid的SDK更丰富、生态更完善,开发自由度显著更高。

再综合考虑Frame在试卷识别等场景下的相机画质限制,研究团队最终选择了乐奇AI眼镜作为这次人机同场考试的硬件测试选手:

而在决定大脑上限的大模型筛选上,团队则对比了多款主流模型,最终锁定了OpenAI目前最新的模型——无论是响应速度还是通用知识能力都较强的ChatGPT—5.2。

软硬件「考生」均已就位,接下来就是重头戏——大考。

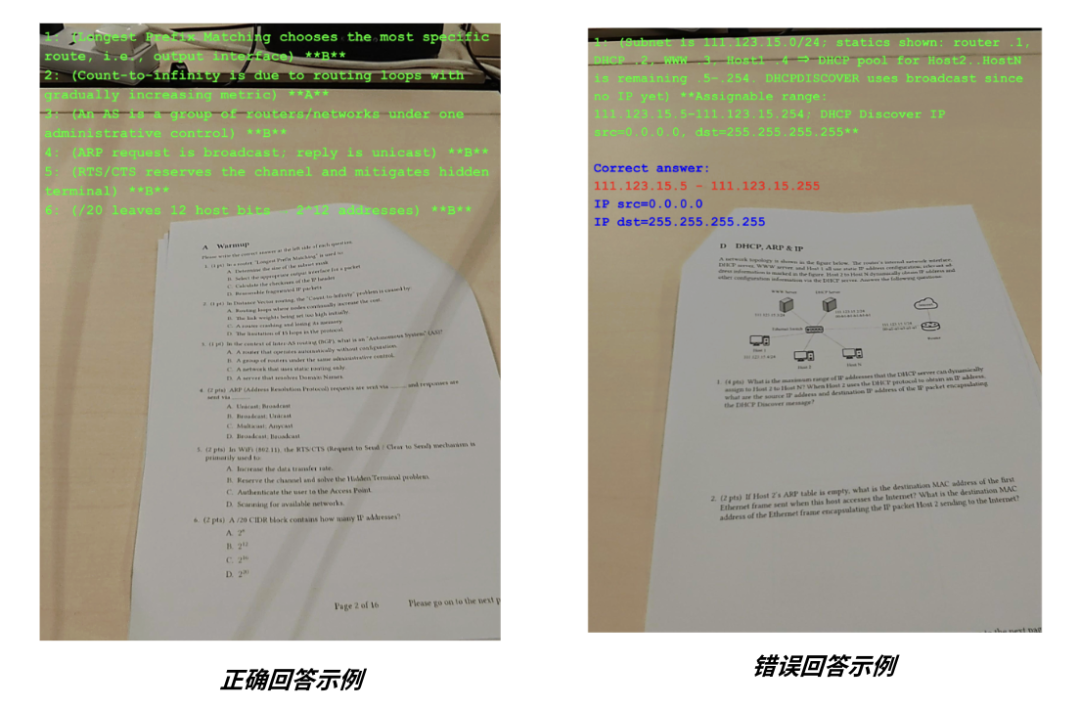

考试过程,可以用丝滑二字来形容:学生低头查看试卷,AI眼镜通过摄像头快速拍摄题目,并经由“眼镜—手机—云端”链路将图像传输至远程大模型完成推理,生成的答案再沿相反路径返回,最终显示在眼镜屏幕上,供学生抄录。

结果您猜怎么着?这款基于Rokid Glasses开发、搭载GPT-5.2模型的AI眼镜,在本次期末考试中拿下92.5分,成绩超过了95%的学生。

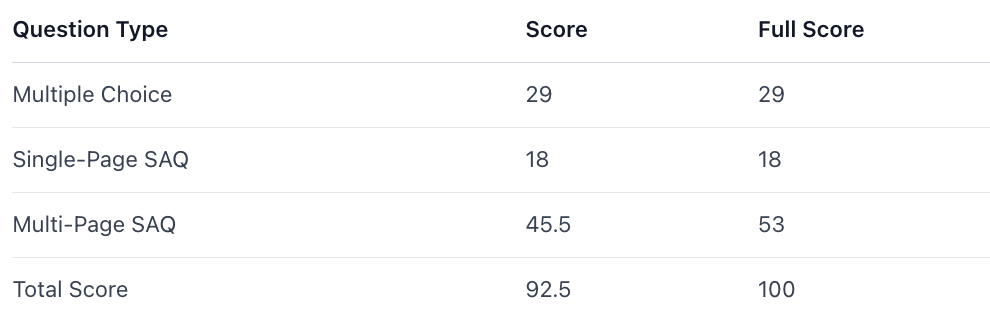

不仅如此,在多项选择题和单页短答题中,乐奇Rokid均获得满分,即便是难度更高的跨页短答题(SAQ),也拿到了大部分分数:

此外,在面对那些核心问题被拆分在不同页码、高度依赖上下文逻辑的跨页短答题,乐奇Rokid依然展现出了极强的推理连贯性。

即便在计算最复杂的部分偶尔出现偏差,但AI给出的中间步骤也算得上非常完整,在处理高压知识任务时也是手拿把掐~

当然,这场测试在跑通软件逻辑的同时,也无情地照出了目前商业AI眼镜存在的《短板》。

首先暴露出来的,是功耗问题。

在考试这样的高压连续场景下,连接本身就已经成为主要耗电源,实验中只要开启Wi-Fi、持续进行高分辨率图像传输,30分钟内眼镜电量就会从100%迅速跌到58%。

换句话说,如果AI眼镜要真正走向全天候、长时间使用,功耗控制和连接稳定性依然是绕不开的工程瓶颈…

不仅如此,项目团队还发现眼镜摄像头的「清晰度」会直接决定AI的视力,一旦题目出现模糊、反光或拍摄角度偏差,再强的模型也只能在不完整信息上做推理,最终体现在答题表现上的,就是明显下滑的稳定性。

但…这场测试带来的冲击和反思,并不只停留在技术层面。

在不做任何特殊照顾的前提下,AI眼镜依然能够把一整套读题—理解—作答的流程跑得又快又稳,这反过来照出了一个更值得注意的问题——

当教学评估主要关注的只是最后有没有交出一份「标准答案」时,它恰好落在了AI最擅长、也最稳定的能力区间里。

也正因为如此,那套以知识点掌握程度和标准解题路径为核心的教学评估方式,在一个早已被各种“学习机”包围的时代,开始显得有些吃力了。

有了聪明的AI,传统教学评估标准还站得住脚吗

不知道大家有没有发现一件挺有意思的事情:

从小学一路考到大学,我们最熟悉的考试,其实一直在反复确认同一件事,那就是有没有把老师讲的内容记住,以及能不能按标准方法,把题一步步算对。

u1s1,在很长一段时间里,这套评估方式确实挺管用。

因为在记忆、计算、按步骤推导这些能力上,人和人之间确实存在明显差距,有人记得牢、算得快,有人就是会漏步骤、算错数。

成绩单上的数字,也确实能覆盖一个人相当大比例的学习表现。

但问题在于,当AI开始在这些评估维度上,也变得又快、又稳、而且几乎不出错时,事情就开始变得微妙了…

此前,一位创业者小孩哥Eddy Xu通过改装Meta智能眼镜,做出了一套可以在国际象棋比赛中实时显示最优解法的“作弊”设备,在几乎不需要自己思考的情况下,就能稳定赢下对局:

在这个过程中,AI眼镜不会紧张,也不会疲劳,更不存在临场波动,一个字形容——稳。

这和乐奇Rokid眼镜参加期末考试的表现其实是同一套逻辑:只要题目规则清晰、评价目标单一,AI就能把读题—理解—推理—作答这套流程稳定跑完。

哪怕脱离纸笔形态,它依然能在高度结构化的考试里,持续拿到高分。

类似的案例并不只发生在个人层面。

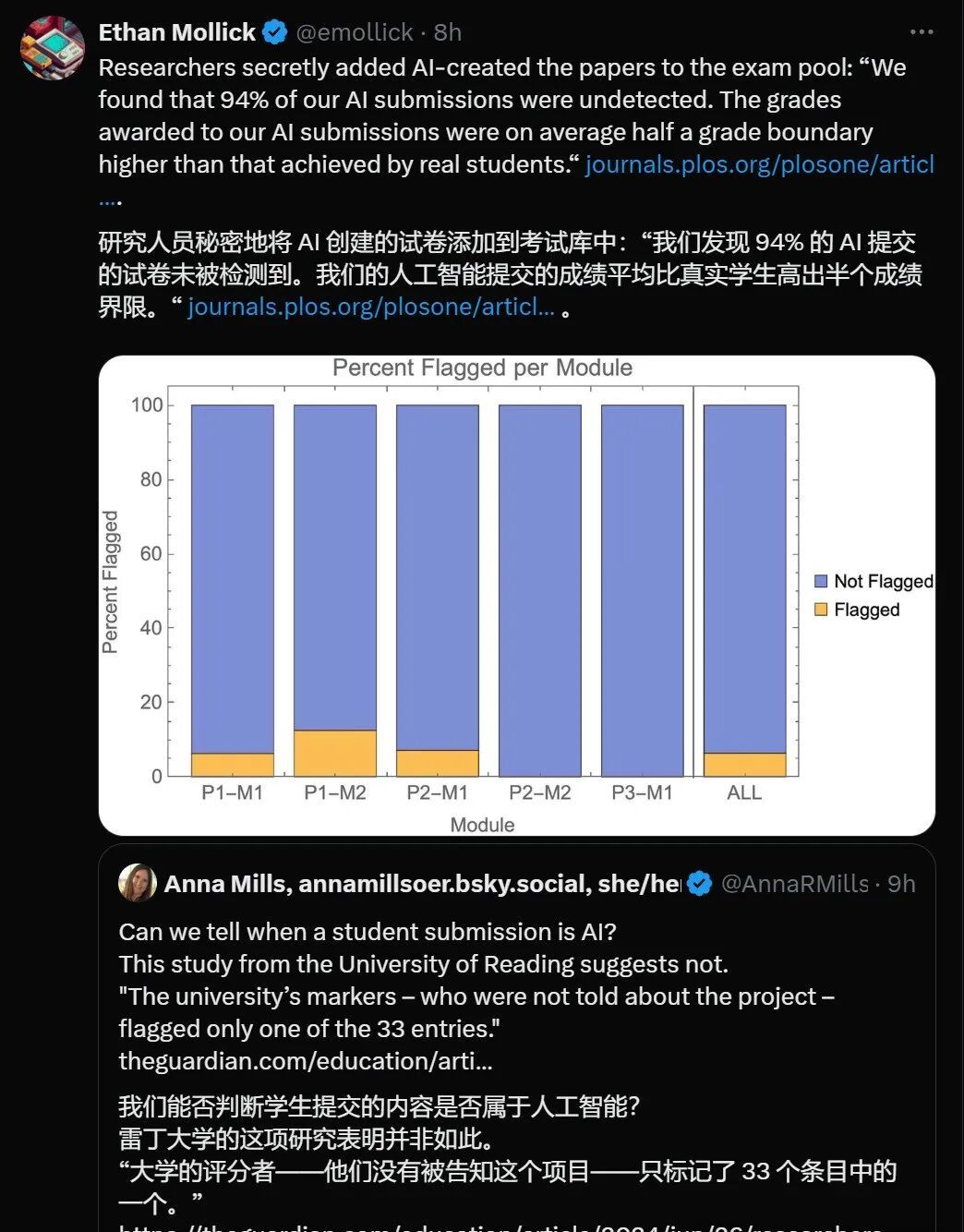

此前,英国雷丁大学的一项研究还发现,当研究人员将AI生成的答卷混入考试题库后,有高达94%的试卷成功“浑水摸鱼”,而这些AI的平均成绩,甚至还明显高于真实学生…(天塌啦

这下是真有点尴尬了——比人比不过,比AI也比不过:

让人大跌眼镜大开眼界的同时,一个原本不那么尖锐的问题被直接推到台前——

当AI或机器比人更擅长按标准作答时,那套以笔试为核心、用来衡量知识点掌握程度的评估体系,到底在测什么?

回过头看教学培养的最初目的,我们会发现很多被反复强调的重要能力,其实并不天然适配“一张试卷”这种形式。

——比如提出好问题的能力。

——在信息不完整时做判断的能力。

——在多种方案之间权衡取舍的能力。

——以及理解现实情境、理解他人立场的能力。

……

这些能力真正指向的是学习过程、思考路径和决策质量,答案是否标准只是其中很小的一部分。

也是长期以来最难被传统笔试捕捉,最容易被系统性忽略,恰好也是AI最难替代、也最能区分学生真实素养的地方。

从结果导向,转向对推理路径、探究过程、跨学科整合与创造性解题能力的整体评估,这也许才是AI眼镜进入考场后,对现有教学评估体系提出的那道真正难题。

评估重心从「交答案」到「交思路」

教育心理学家加德纳曾在《Frames of Mind》中提到,人类至少拥有8种不同类型的智能——

包括语言、逻辑数学、空间、音乐、人际、内省、身体运动、自然观察。

从这个视角看,人类能力本身就是一个高度多维的结构,而我们所熟悉的教学评估体系,长期以来却只集中捕捉了其中非常狭窄的一段。

这也不难解释,为啥一些在标准化测试中表现并不突出的学生,反而能在真实世界中展现出更强的创造力、协作能力和复杂问题解决能力。

毕竟单一考试成绩更多反映的只是学生在「标准化环境」中的发挥稳定性,像真实情境下的个人综合素质其实显露不太出来……

也正因如此,如何评估创新能力、批判性思维和复杂问题解决能力,正在成为教育评估体系绕不开的一个现实难题。

目前一些指向不同方向的评估尝试,已经出现~

前不久,纽约大学Stern商学院教授Panos Ipeirotis推出了一套由AI支撑的口试评估方式,学生不仅要提交作业,还需要当场解释自己的决策依据和思路走向,在对话中把理解与推理展开来。

这套机制中,AI先充当考官进行追问,再参与到后续评估环节。

Claude、Gemini和ChatGPT会分别对口试转录进行独立评分,随后交叉审查并修订结果,用来判断学生是否真正理解问题,同时暴露教学中的共性盲区:

怎么说呢,感觉这种做法谈不上专门“对付”AI,但确实把教学评估重心往理解本身挪了一步。

类似的变化并非个例,此前《华盛顿邮报》也提到,目前国外部分高校已经开始引入口试、展示型作业等形式,本质上也是为了让学生的思考过程变得显现。

所以回过头看,当搭载GPT-5.2的乐奇AI眼镜走进考场并交出高分时,AI是否「考赢」了学生似乎也没有那么重要了。

它更像一次特别但清晰的显影实验,让一个长期存在却很少被正视的问题浮出水面:

传统教学评估高度依赖最终答案,却几乎无法刻画整个学习过程。

分数当然是有意义的,但它所能解释的范围正在变窄,理解是否真正发生、思路是否连贯、判断是否经过取舍,这些关键环节,仍然被压缩成一个单一结果,难以被区分和看见。

也正是在这一点上,单纯地把技术挡在门外,其实已经很难回应问题本身了。(也不见得阻挡得了…

更现实的挑战,变成了如何让学生把AI用在信息整理、方案推演和假设验证上,把人的精力集中到判断、理解和选择这些无法被「外包」的环节。

当工具可以稳定完成信息提取与标准作答,课堂与考试是否还能区分不同层次的思考,正被推到台前。

本文转自:凤凰网科技

原文地址: https://tech.ifeng.com/c/8ph8448tSc3

小同爱分享7 天前

失败是成功之母,但我的失败,好像不孕不育。 - 小同爱分享

小同爱分享12 天前

灵山有灵事事灵验,命运有命运运不济。 - 小同爱分享